AI/AI 동향

오픈소스로 가자! OpenLLaMA 의 등장

RevFactory

2023. 5. 5. 21:38

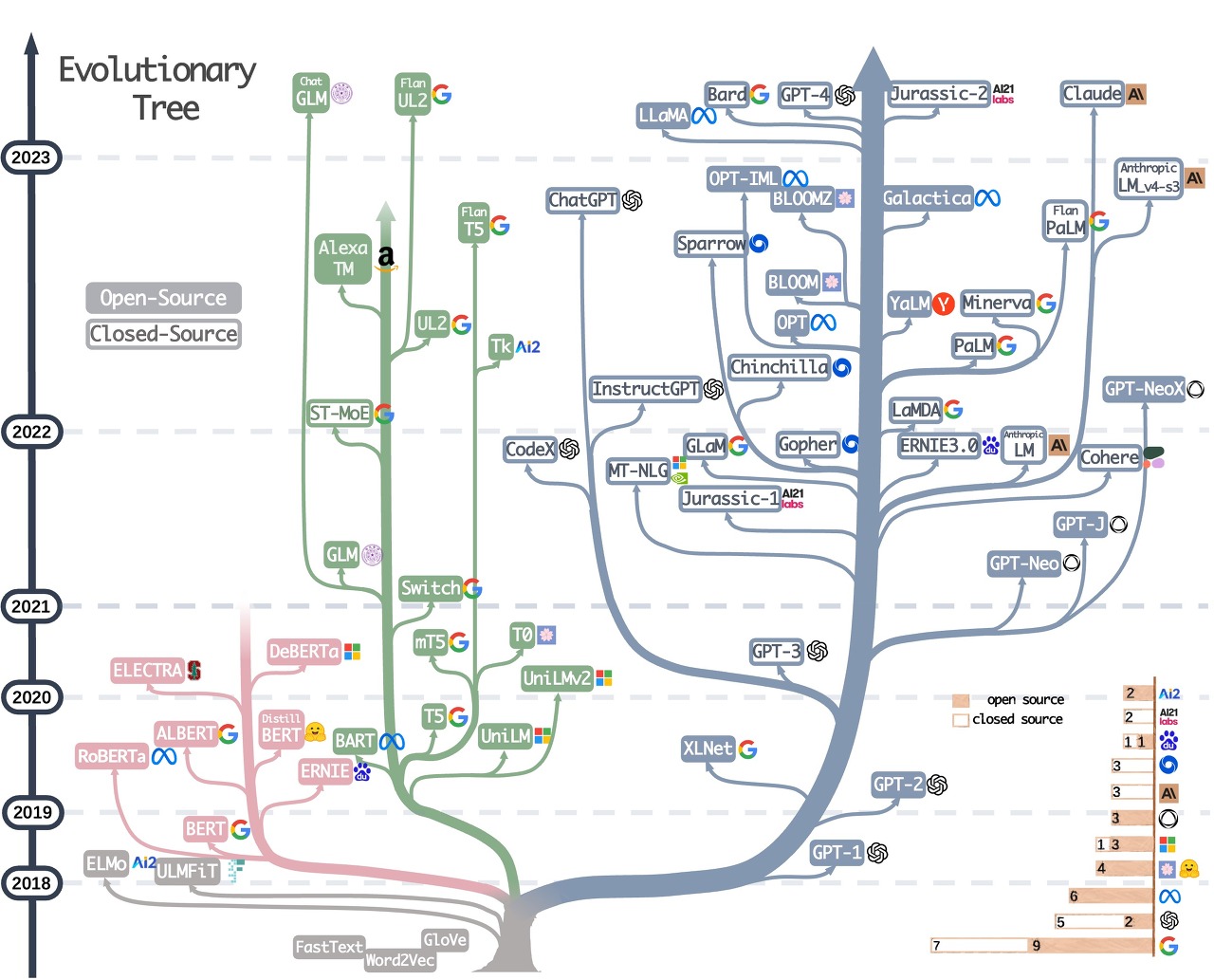

아래 차트를 보더라도 정말 많은 LLM(Large Language Model) 이 있죠.

차트에서 진하게 음영처리 된 것은 오픈소스로 공개된 것이며, 테두리만 표시된 것은 소스가 공개되지 않은 것입니다. 설령 LLM이 오픈소스로 공개되었다고 해도, 학습 결과인 가중치(weights)가 공개되어 있지 않아 모델을 실행해 볼 수는 없었습니다.

하지만 Meta의 LLaMA 는 오픈소스로 공개 (GitHub) 하면서 일부 사용자들에게 승인 과정을 통해 모델 가중치 및 토크나이저를 다운로드 할 수 있도록 했는데 이 가중치가 유출되어 토렌트에 퍼지다가 결국 모두 공개되어버렸죠. (관련기사-Facebook의 강력한 대규모 언어 모델이 온라인으로 유출됩니다.) Meta는 LLaMA의 가중치 유출에 대해 공식 반박하지는 않았지만, 여전히 승인된 개인에게만 엑세스 권한을 부여하는 정책을 유지하고 있습니다. 또한 저작권 침해 또는 부적절한 무단 사용에 해당하는 모델의 게시를 중단 요청하고 있습니다.

한편, 오픈소스 커뮤니티에서는 LLaMA가 모델을 학습시키기 위해서는 수천만 달러의 비용이 드는 강력한 슈퍼컴퓨터가 필요하지만 모델의 실행은 데스크탑에서, 심지어는 구형 스마트폰에서도 작동할 수 있었기에 매우 열광했습니다. 응답 품질을 높이기 위해 기존 모델에 파인튜닝을 시도했습니다.

그 중 GPT 3.5(text-davinci-003) 를 이용하여 Instruction-following (학습 데이터를 자동 생성) 데이터로 5.2만 건으로 파인튜닝시킨 Stanford 대학의 Alpaca 에 매우 주목하기 시작했습니다. 단돈 500달러로 자동 생성한 데이터의 파인튜닝만으로 LLaMA의 응답 품질을 ChatGPT 에 가깝게 나오도록 했으니까요. 물론 이 둘을 비교했을 때, ChatGPT의 품질이 훨씬 좋긴했습니다만 많은 개발자들은 가능성을 보았습니다.

Alpaca 가 성공적이긴 했지만 ChatGPT의 GPT-4 의 등장으로 ChatGPT만큼의 응답 품질을 따라가기에는 오픈소스 커뮤니티에서도 더 다양한 실험이 필요했습니다. 마치 골리앗이 다윗을 이기고자 하는 열망이랄까요. 이후, ChatGPT 의 질문과 답변을 공유하던 ShareGPT 의 공개된 약 7만건의 데이터로 LLaMA를 파인튜닝한 Vicuna **가 다음으로 주목받았습니다. 데이터에는 GPT-4 의 응답을 포함하고 있었기에 Alpaca 보다 더 좋은 결과를 주었으며, 평가결과 GPT 3.5와 Google의 Bard 대비 90%에 이르는 품질로 측정되었습니다. 이 때 평가는 GPT-4를 사용했다고 합니다. :-)

이외에도 GPT-4ALL , Open-Assistant (13,000명 이상의 지원자로부터 수집한 데이터 세트에서 학습) 등도 추가로 공개되면서 오픈소스 커뮤니티는 더욱 더 모델에 관심을 갖고 많은 이들이 참여하고 있습니다.

다만, 가중치가 유출되었더라도 Meta의 LLaMA 오픈소스는 GPL-3.0 오픈소스 라이선스이며, 연구 목적으로만 사용 가능한 비상업적으로 사용 제한을 하고 있습니다. LLaMa 기반의 오픈소스를 기업에서 사용하기 위해서는 LLaMA 가 비상업적 사용 제한을 해제하거나, LLaMA의 대안을 찾아야 합니다.

✨✨ OpenLLaMA 의 등장 ✨✨

OpenLLaMA가 어떤 의미를 갖는지 이해를 돕기위해서 여기까지 서론이 아주 길었네요!

LLaMA의 오픈소스가 있기 때문에 우리는 모두 아키텍처도 알고 있습니다.

누군가 실제로 다시 구현을 하고, 다시 학습도 시켜서 오픈소스로 공개한다면, LLaMA의 대안이 될 수 있습니다. 이에 OpenLLaMA 가 등장했습니다. (GitHub) 이번엔 버클리 공대에서 나왔네요.

현재 2,000억개의 토큰으로 학습된 70억개의 OpenLLaMA 가 프리뷰로 공개되었습니다. 그리고 사전 학습된 OpenLLaMA 모델의 PyTorch 및 Jax 가중치와 평가 결과, 그리고 기존 LLaMA 모델과의 비교를 제공하고 있습니다. (5월 3일 3,000억개 토큰까지 학습되었네요.)

JAX and PyTorch Weights on Huggingface Hub

여러 측정 항목들에 대한 평가 점수를 보면 LLaMA 의 수치와 거의 비슷하게 측정되고 있으며, 낮은 것도 있지만 어떤 항목은 오히려 높게 측정되기도 하고 있습니다.

현재 프리뷰라고 하는 이유는 실제 LLaMA가 1조 2천억개의 토큰으로 학습되었기 때문에 그 수준에 이르려면 아직 시간이 더 필요합니다. 그들은 실제로 훨씬 더 큰 데이터 세트로 모델을 재훈련하고 있으며 조만간 사용할 수 있을 것입니다.

단, 차이점은 LLaMA에서 학습한 원본 데이터에는 직접 엑세스 할 수 없기 때문에 RedPajama 라는 데이터 세트를 사용하고 있다고 합니다. RedPajama 는 LLaMA 논문에 설명된 레시피에 따라 생성된 1조 2천억 개의 토큰 완전 개방형 데이터 세트입니다.

우리는 왜 오픈소스에 관심을 갖아야 할까요?

1. 데이터가 Privacy 가 필요한 경우 오픈소스 LLM 모델은 로컬 혹은 내부 서버에서 실행이 가능합니다.2. 대규모 언어 모델을 비즈니스 목적에 맞게 다시 학습을 하거나, 파인튜닝을 통해 새로운 소규모 모델을 운영할 수 있습니다.3. OpenAI 등에서 제공하는 대형 LLM을 사용하는데 소요되는 비용과 의존성에 따른 잠재적인 리스크를 줄일 수 있습니다.

* 혹시라도 위 내용 중 수정이 필요한 부분이 있다면 언제든지 댓글 환영입니다.